فایل Robots.txt چیست؟

موتورهای جستجو به کمک ربات های خزنده خود می توانند سایت های مختلف را بررسی کنند؛ اما این امکان برای شما وجود دارد که جهت حرکت یا به عبارتی مسیر حرکت ربات های خزنده را مشخص کنید. این کار به کمک فایل ربات امکان پذیر می باشد. فایل Robots.txt، در واقع یک فایل متنی ساده است که در مسیر اصلی سایت یا روت دایرکتوری ( Root Directory ) قرار می گیرد یعنی می توانید آن را روی سرور خود قرار دهید تا دسترسی ربات ها را کنترل کند این فایل به ربات دستور می دهد کدام صفحات را بخزد و کدامیک را نخزد.

این فایل بخش های قابل دسترسی یا محدوده شده برای ربات ها را تعریف می کند. به کمک اطلاعاتی که در این فایل قرار می دهید، می توانید به ربات های خزنده بگویید که کدام یک از صفحات سایت را دیده و ایندکس کنند و کدامیک را نادیده بگیرند. می توان اینطور گفت که اولین چیزی که ربات های خزنده در سایت شما مشاهده می کنند، همین فایل است. در ادامه به شما نحوه ساخت فایل robots.txt را می گوییم. شما می توانید اطلاعات این فایل را با جستجو آدرس زیر مشاهده کنید:

www.YourWebsite.com/robots.txt

دستورات موجود در فایل Robots.txt

در حالت کلی 5 دستور مهم در فایل robots.txt وجود دارد که در ادامه به معرفی هر یک از آن ها می پردازیم.

User-agent

این دستور به تنهایی یک دستور کامل نیست و در کنار دستورهایی که در ادامه معرفی می کنیم، استفاده می شود. این دستور نوع رباتی که از دستورات بعدی پیروی می کند را مشخص می کند.

اگر بخواهید برای تمام ربات ها دستور ایجاد کنید باید بعد از عبارت User-agent علامت (*) را قرار دهید مانند نمونه زیر:

*:User-agent

اما اگر بخواهید برای یک ربات خاص دستور ایجاد کنید باید اسم ربات را بنویسید. برای مثال برای دستور به ربات گوگل باید مثل نمونه زیر عمل کنید:

User-agent: Googlebot

Disallow

دستور Disallow به معنای اجازه ندادن است. از طریق این دستور به ربات مورد نظر می گویید کدام صفحه را نباید بخزد. در واقع این دستور، ادرس هایی را مشخص می کند که باید از دید ربات های جستجو پنهان بماند. اگر قصد دارید برای چند صفحه این دستور را صادر کنید باید برای هر کدام جداگانه دستور بنویسید. در زیر نمونه ای از این دستور را قرار دادیم.

*:User-agent

Disallow: /photos

Allow

این دستور به معنای اجازه دادن است و به ربات هایی که مشخص می کنید اجازه می دهد موارد مشخص شده را بخزند. نوشتن این دستور ضرورت چندانی ندارد زیرا ربات ها به صورت پیش فرض تمام موارد را می خزند. اما برای مواقعی که می خواهیم به ربات بگوییم یک فایل را در پوشه ای که Disallow شده است، مشاهده کند کاربرد دارد. برای مثال در مورد قبلی به ربات گفتیم فایل تصاویر را خزش نکند، ولی می خواهیم یک تصویر در این فایل را مشاهده کنند در این موقع از این دستور به صورت زیر استفاده می کنیم:

* :User-agent

Disallow: /photos

Allow: /photos/seo.webp

Crawl-delay

این دستور میزان خزش سایت را بر حسب ثانیه تعریف می کند. می توانید در مقابل این دستور عددی بین 1 تا 30 بنویسید و به ربات بگویید به میزان مثلا 10 ثانیه صبر کند و سپس سایت را خزش کند. البته دقت داشته باشید این دستور برای ربات های گوگل تاثیری ندارد.

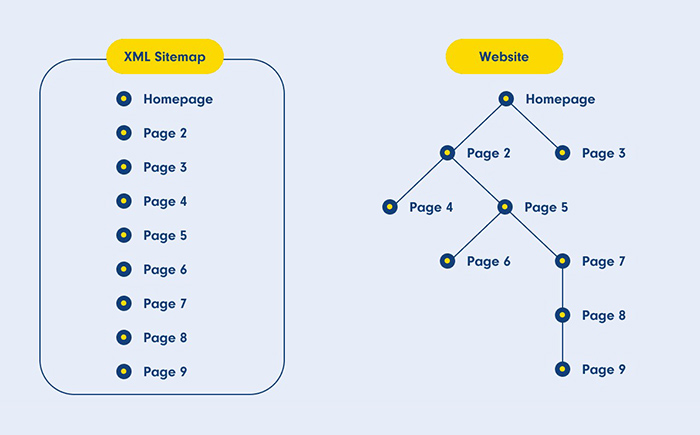

Sitemap

با وارد کردن آدرس سایت مپ در مقابل این دستور، مسیر نقشه سایت را به موتورهای جستجو نشان می دهید. در ادامه این مطلب نحوه نوشتن این دستور را توضیح داده ایم.

آموزش ساخت فایل robots.txt

پیش از آنکه برای ساخت فایل robots.txt اقدام کنید، اطمینان حاصل کنید که چنین فایلی وجود ندارد؛ برای این کار کافیست آدرس www.YourWebsite.com/robots.txt را سرچ کنید. اگر با صفحه 404 مواجه شدید، یعنی این فایل وجود ندارد.

اما اگر با صفحه ای شامل کدهای User-agent و … روبرو شدید، باید برای مدیریت فایل به کنترل پنل هاست سایتتان مراجعه کنید. برای ویرایش فایل robots.txt، آن را در یک ویرایشگر متنی ساده باز کرده و تغییرات لازم را اعمال کنید. سپس آن را ذخیره کرده و جایگزین فایل قبلی کنید.

اما اگر چنین فایلی در هاست سایتتان نبود، از طریق برنامه Notepad ویندوز یک فایل متنی بسازید و با نام robots آن را ذخیره کنید؛ پس از آن دستورات مورد نظرتان را در آن درج کرده و پس از ذخیره کردن، آن را در روت اصلی سایت آپلود کنید.

نکته بسیار مهمی که باید به آن دقت کنید، این است که فایل robots.txt به حروف بزرگ و کوچک حساس است. به عنوان مثال اگر بخواهید برای فایلی با نام File.php محدودیتی ایجاد کنید و به اشتباه در فایل robots.txt، نام آن را file.php بنویسید، هیچ محدودیتی برای آن اعمال نکرده اید.

نحوه تست فایل robots.txt

اگر بخواهید از روش معمولی استفاده کنید، باید فایل robots.txt را باز کرده و دستورات داخل آن را بررسی کنید. اما راه حرفه ای تری نیز وجود دارد که شما می توانید به کمک ابزار تست فایل robots.txt در کنسول گوگل آن را تست کنید.

برای استفاده از این ابزار مراحل زیر را طی کنید:

- ابتدا وارد سایت Google Search Console شوید

- روی بخش robots.txt Tester کلیک کنید

- گزینه Test را انتخاب کنید

در صورتی که مشکلی در فایل robots.txt وجود نداشته باشد، دکمه قرمز رنگ تست، به رنگ سبز و Allowed تغییر می کند. اما اگر مشکلی باشد، دستور مشکل دار هایلایت و مشخص می شود. علاوه بر این، این ابزار امکانات دیگری را نیز در اختیار شما قرار می دهد؛ مثلا می توانید از طریق بخش URL Tester، آدرس صفحات مختلف سایت را بررسی کنید تا متوجه شوید که برای ربات ها مسدود شده اند یا خیر.

همچنین به کمک این ابزار می توانید محتویات فایل robots.txt را تغییر بدهید. اما برای اعمال تغییرات در سایتتان، باید محتوای ویرایش شده را جایگزین محتوای قبلی در فایل robots.txt در هاست خود کنید. برای این کار کافیست پس از ویرایش متن، روی دکمه Submit کلیک کنید تا به بخش بعدی بروید. در بخش بعدی شما می توانید فایل robots.txt را دانلود کنید، سپس فایل جدید را جایگزین فایل قبلی کنید. در نهایت به این صفحه برگشته و دکمه Submit را بزنید.

آموزش ساخت فایل robots txt در وردپرس

مواردی که در بالا برای ساخت فایل robots txt گفته شد، برای وردپرس نیز قابل انجام است. اما نکاتی را باید در این زمینه رعایت کنید:

نکته اول

در سال های گذشته برای مسدود سازی دسترسی ربات ها به پنل مدیریت سایت وردپرس، باید از طریق پنل مدیریتی وردپرس، اقدام می کردیم. اما در سال 2012 با بروزرسانی وردپرس، دیگر این کار ضرورتی نداشت؛ چرا که وردپرس به صورت پیشفرض قابلیتی را به تگ هدر فایل اضافه کرده که تگ noindex و مسدود سازی یا disallow در آن گنجانده شده است. در نتیجه صفحه پنل مدیریت سایت وردپرس بدون هیچ اقدام خاصی از لیست ایندکس موتورهای جستجو خارج شده است.

نکته دوم

در وردپرس به صورت پیشفرض فایل robots.txt با نام فایل مجازی robots.txt یا Virtual robots.txt یاد می شود. یعنی شما نمی توانید به صورت مستقیم به این فایل دسترسی داشته و آن را ویرایش کنید. شما میتوانید تنها از طریق باز کردن آدرس http://www.example.com/robots.txt در مرورگر به این فایل دسترسی داشته باشید.

دستورالعمل پیش فرضی که در فایل robots.txt قرار دارد، به صورت زیر است:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

طبق این دستور، ربات ها اجازه دسترسی به صفحه admin-ajax.php را دارند؛ اگر می خواهید دسترسی به این صفحه را غیر فعال کنید، باید به تنظیمات وردپرس رفته و گزینه Search Engine Visibility را فعال کنید.

ساخت robots.txt وردپرس

برای ساخت فایل robots.txt در وردپرس ابتدا وارد هاست سایتتان بشوید؛ سپس از آنجا روی گزینه File Manager کلیک کنید تا بتوانید فایل ها مختلف موجود در سایتتان را مشاهده کنید.

پس از ورود به این گزینه، مسیر /public_html/ را انتخاب کنید. اکنون فایلی که با برنامه notepad یا هر نرمافزار ویرایشگر متن دیگری که ساخته اید را با نام robots.txt ذخیره و روی هاست آپلود کنید. برای این کار کافیست گزینه Upload را انتخاب و فایل را به هاست خود اضافه کنید.

علاوه بر این شما می توانید با کلیک روی گزینه " FILE+ " طبق تصویر زیر، در فیلد New File Name، فایلی را با نام robots.txt وارد کرده و در نهایت Create New File کلیک کنید تا فایل شما ساخته شود.

اکنون به کمک دستورات زیر می توانید فایل robots.txt را کنترل کنید.

به عنوان مثال اگر در هاست خود پوشه ای با نام "new folder " دارید و می خواهید که ربات ها به آن دسترسی نداشته باشند، باید قطعه کد زیر را در فایل robots.txt خود قرار بدهید:

User-agent: *

Disallow: /new folder/

دستورات تعیین سطح دسترسی فایل robots.txt در وردپرس

به طور کلی گوگل ربات های مختلفی را طراحی کرده است که هر کدام وظیفه بررسی مورد خاصی را در سایت ها دارند. به عنوان مثال ربات Googlebot وظیفه ایندکس صفحات را دارد یا ربات Googlebot-image، برای بررسی تصاویر یک سایت طراحی شده است. شما می توانید دسترسی تمامی این ربات ها را به کمک دستورات زیر محدود کنید:

محدود کردن دسترسی به یک تصویر:

user-agent: Googlebot-image

disallow: /photo/

غیر فعال کردن دسترسی به کل سایت:

Disallow: /

غیر فعال کردن دسترسی به یک پوشه خاص:

Disallow: /name-folder/

Disallow: /name-folder/file/

محدود کردن به دسترسی به یک فایل:

Disallow: /name-folder/name-file.format (pdf,jpg,...)

محدود کردن فایلهایی به فرمت خاص:

Disallow: /*.gif$

Disallow: /*.pdf$

Disallow: /*.docs$

دسترسی نقشه سایت در فایل robots.txt:

به طور کلی شما می توانید به دو روش نقشه سایتتان را به گوگل معرفی کنید؛ برای این کار می توانید از سرچ کنسول یا فایل robots.txt استفاده کنید. اما پیش از آن بهتر است با مطالعه مطلب " ساخت سایت مپ " نقشه سایتتان را بسازید. پس از آن بهتر است از طریق سرچ کنسول نقشه سایتتان را به گوگل معرفی کنید؛ برای این کار باید سایتتان را در سرچ کنسول ثبت کرده باشید. در مطلب " ثبت سایت در سرچ کنسول " به شما آموزش های لازم را داده ایم.

اما اگر می خواهید از طریق فایل robots.txt این کار را انجام بدهید، باید قطعه کد زیر را به فایل خود اضافه کنید:

Sitemap:https://example.com/sitemap.xml

نحوه ویرایش فایل robots.txt در وردپرس

با توجه به آنچه گفته شد، امکان ویرایش مستقیم فایل robots.txt در وردپرس وجود ندارد. به همین دلیل باید برای ویرایش آن، یک فایل جدید را ایجاد کرده و در هاست مجدد بارگذاری کنید. زمانی که فایل جدید robots.txt ساخته می شود، فایل مجازی به صورت خودکار غیر فعال می شود.

ضرورت داشتن فایل robots.txt چیست؟

در صورتی که این فایل در هاست سایتتان آپلود نشده باشد، خزندگان و ربات های موتورهای جستجو می توانند به تمام صفحات سایت شما دسترسی پیدا کرده و آنها را مورد بررسی قرار دهند.

اگر فایل robots.txt به درستی در سایت آپلود نشود، چه می شود؟

اگر این فایل به درستی تهیه نشده باشد یا به صورت کامل در هاست آپلود نشده باشد، ربات های خزنده مانند قبل تمامی صفحات سایت را ایندکس می کنند. در واقع ربات ها دستوراتی را اجرا می کنند که به صورت دقیق و منطبق با رفتار آنها تعریف شده باشد. در غیر اینصورت وظیفه طبیعی و اصلی خود را انجام می دهند.

دلایل اصلی استفاده از فایل robots.txt

اما دلایل استفاده و کاربرد فایل robots.txt چیست؟

1. بهبود عملکرد بهینه سازی سایت

وب سایت های بزرگ و پر بازدید، روزانه هزاران بار توسط ربات های مختلف مورد بررسی قرار می گیرند. این ربات ها در طی دو مرحله یعنی بررسی و ایندکس، سایت را بررسی می کنند. حال فرض کنید روزانه بیش از صدها ربات یک سایت را بررسی کنند؛ این اتفاق سبب کند شدن سرعت لود سایت خواهد شد. چرا که تمام بخش های سایت و هاست، تحت تاثیر هزارن ربات قرار گرفته است.

لازم به ذکر است که این مورد برای سایت های کم بازدید، تاثیر کمتری دارد. اما به هر جهت سایت هایی که باید روزانه ترافیک زیادی را هندل کنند، با اضافه شدن حجم زیادی از ربات ها نیز، دچار مشکل خواهند شد. به همین جهت است که سئوکاران برای بهبود سرعت سایت، دسترسی ربات ها را محدود می کنند. در واقع با این کار اجازه بررسی برخی از بخش های سایت که از نظر سئو اهمیت کمتری دارند را به ربات ها نمی دهند.

2. مدیریت دسترسی موتورهای جستجو

از رایج ترین دلایل استفاده از فایل robots.txt، محدود کردن دسترسی ربات های خزنده به بخش های مختلف یک سایت است. قطعا این سوال برایتان پیش خواهد آمد که چرا برخی از صفحات نباید ایندکس شوند؟ ایندکس شدن برخی از صفحات سایت می تواند نتایج نامطلوبی را برای شما داشته باشد.

به عنوان مثال فرض کنید شما به مناسبت های مختلف، جشنواره ای را در سایت خود برگزار می کنید و برای این جشنواره ها صفحاتی را ایجاد می کنید. ضرورتی ندارد که ربات های خزنده این صفحات را ایندکس کنند؛ چرا که پس از مدتی غیر فعال شده و از طرفی بار محتوایی زیادی نیز ندارند. به همین دلیل در فایل robots.txt، ذکر میکنیم که این صفحات ایندکس نشوند.

چرا که در صورت ایندکس شدن، ممکن است به عنوان صفحات زامبی یا بی ارزش شناخته شوند. لازم به ذکر است که ایندکس نشدن یک صفحه از سایت، به معنای دیده نشدن آن صفحه توسط کاربر نیست. فقط در نتایج آورده نشده و توسط ربات ها بررسی نمی شود.

3. مدیریت لینک های سایت

یکی از تکنیک های سئو کلاه سیاه، تکنیک URL Cloacking می باشد؛ در واقع در این تکنیک شما آدرس یک صفحه را از دید موتورهای جستجو مخفی می کنید. یکی از دلایل استفاده از فایل robots.txt، مدیریت همین صفحات است. با این تکنیک شما می توانید آدرس صفحات را از دید کاربر و موتور جستجو مخفی نگه دارید.

بیشترین کاربرد URL Cloacking، در سیستم همکاری در فروش یا Affiliate Marketing به چشم می خورد. با این کار شما می توانید لینک های ایجاد شده در Affiliate را مدیریت کرده و آدرس آنها را مخفی کنید. در نهایت کاربر مجبور می شود روی آنها کلیک کند.

4. بهینه سازی بودجه خزش

بررسی صفحات هر سایتی توسط خزنده های گوگل، دارای میزان بودجه خزش یا Crawl Budget مشخصی می باشد. بنابراین مهم است که بودجه خزش سایت شما صرف بازدید کدام یک از صفحات سایت تان می شود. میزان بودجه خزش هر سایت با توجه به مدت زمان راه اندازی، تعداد صفحات، تعداد بک لینک ها و ... متفاوت است. شما می توانید با استفاده از فایل Robots.txt آن صفحاتی که ارزش خزش دارند را در اختیار کراولر های موتور جستجو قرار دهید. در مقاله " بودجه خزش چیست " به طور کامل در این باره صحبت کرده ایم.

❔︎ سوالات متداول

فایل robots.txt چیست؟

فایل robots.txt یک فایل متنی ساده است که در مسیر اصلی سایت (Root Directory) قرار میگیرد و به رباتهای موتورهای جستجو دستور میدهد کدام صفحات سایت را بخزند و کدام صفحات را نادیده بگیرند.

چرا باید فایل robots.txt داشته باشیم؟

این فایل به شما کمک میکند دسترسی رباتها به بخشهای مختلف سایت را مدیریت کنید، بودجه خزش (Crawl Budget) را بهینه کنید و از ایندکس شدن صفحات غیرضروری جلوگیری کنید.

چگونه فایل robots.txt را بسازم؟

میتوانید یک فایل متنی ساده با نام robots.txt ایجاد کرده و دستورات مورد نظر خود را در آن وارد کنید و سپس در روت سایت آپلود کنید. در وردپرس، فایل robots.txt به صورت مجازی ساخته شده و میتوانید آن را از طریق هاست یا افزونهها ویرایش کنید.

چه دستورات مهمی در فایل robots.txt وجود دارد؟

- User-agent: مشخص میکند کدام ربات دستورات بعدی را دنبال کند.

- Disallow: تعیین صفحات یا پوشههایی که رباتها نباید بخزند.

- Allow: اجازه دسترسی به فایل یا پوشهای که ممکن است Disallow شده باشد.

- Crawl-delay: تعیین فاصله زمانی بین بازدید رباتها از سایت (تاثیر محدود برای گوگل).

- Sitemap: معرفی مسیر نقشه سایت به موتورهای جستجو.

آیا میتوانم دسترسی رباتهای خاص را محدود کنم؟

بله، با استفاده از دستور User-agent میتوانید رباتهای مشخص مانند Googlebot یا Googlebot-Image را کنترل کنید و صفحات، تصاویر یا فایلهای خاص را محدود کنید.

در پایان

در این محتوا به شما گفتیم که فایل Robots.txt چیست و چه کاربردی دارد؟ همانطور که گفتیم به کمک فایل Robots.txt میتوانید ربات های خزنده گوگل را تا حدی کنترل کرده و از ایندکس شدن و بررسی صفحات بی ارزش نیز جلوگیری کنید. با این کار می توانید بودجه خزش سایتتان را صرف صفحات با ارزش تر کنید و در نتیجه سئو تکنیکال سایتتان را افزایش دهید.